GPT Builder 微軟 Copilot GPT

微軟釋出GPT Builder工具,可打造客製版GPT

微軟最近宣布對付費的Copilot Pro方案用戶,釋出Copilot GPT Builder工具,來讓使用者打造Copilot GPT客製版。Copilot GPT Builder和OpenAI去年底推出的GPT Builder開發工具很像,可讓中小企業或個人用戶以文字輸入指令,打造具有專門用途的AI聊天機器人,像是在購物網站建一個根據用餐計畫建議購物清單的Copilot GPT。

Copilot Pro則是今年1月微軟公布給個人用戶的Copilot方案,費用為每人每月20美元。Copilot Pro底層模型也將提升到GPT-4 Turbo。微軟也提供Copilot Pro用戶使用GPT Builder的指示,用戶需安裝Edge或Chrome瀏覽器,連到copilot.microsoft.com或chat.bing.com網站,再登入微軟帳號操作即可。(詳全文)

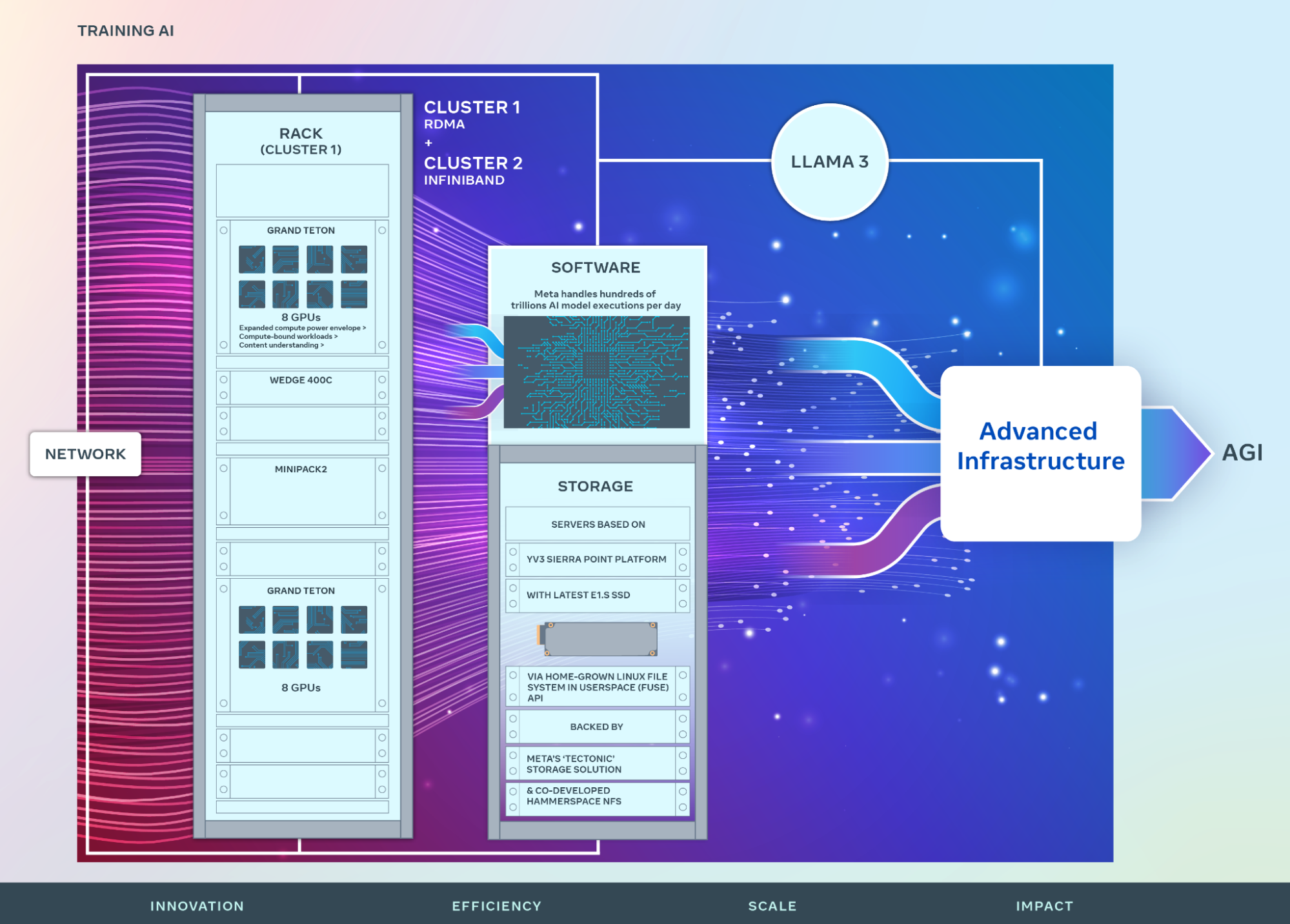

Meta GenAI 基礎設施

Meta公開GenAI基礎設施

Meta最近公開自家使用的GenAI基礎設施,內含兩個各用24,576個Nvidia H100 GPU的大型資料中心叢集,以及相關的網路、運算與儲存部署。早在2022年,Meta就揭露自己打造的AI叢集AI Research SuperCluster,當時就稱這是全球速度最快的超級電腦之一,使用了1.6萬個Nvidia A100 GPU。

而最近Meta揭露的GenAI叢集,雖採兩種不同的網路架構,但都配備了24,576張Nvidia H100 GPU。因為,他們每天要執行數百兆個AI模型,因此需要客製自己的硬體、軟體和網路架構,來確保資料中心的高效運作。其中一個叢集是基於Arista 7800、Wedge400與Minipack2開放運算計畫(OCP)機架交換器的RDMA over Converged Ethernet(RoCE)解決方案,可透過乙太網路自遠端直接存取記憶體的網路協定,是高頻寬、低延遲的網路基礎設施。

另一個叢集則採Nvidia的Quantum2 InfiniBand架構,同樣也是專為高效能運算的低延遲與高頻寬所設計。這兩個叢集的端點互連速度皆高達400 Gbps,採用不同網路架構,將有利Meta評估不同類型的互連對大規模訓練的適用性及可擴展能力,以作為未來設計和建置更大規模叢集的參考。(詳全文)

DeepMind 通用AI AI代理

DeepMind開發通用AI,可接收指令玩遊戲

幾年來,DeepMind一直專攻AI代理人玩遊戲研究,最近開發一套新AI代理Scalable Instructable Multiworld Agent(SIMA),是第一個能理解廣泛遊戲世界的AI代理,可像人類一樣遵循自然語言指令、執行任務。

就技術架構來說,SIMA由兩個模型組成,一個專門處理圖像和語言映射的模型,另一個則是預測螢幕接下來會發生什麼事件的模型。團隊表示,SIMA不需存取遊戲原始碼,也不需要客製的API,只需兩個輸入值,即螢幕畫面和用戶所提供的簡單自然語言指令,並使用鍵盤和滑鼠來控制遊戲角色。

DeepMind與8個遊戲工作室合作,在9款3D遊戲中訓練和測試SIMA。團隊對SIMA進行了600項基本技能評估,涵蓋導覽、操作物件和使用選單等,目前SIMA可在10秒內完成簡單任務,DeepMind希望SIMA之後能完成需要高階策略規畫,並由多個子任務組合才能完成的複雜任務。他們也發現,SIMA具備泛化能力,能將學習到的技能和策略,應用在沒見過的環境中。(詳全文)

IBM NASA 科學文獻

IBM聯手NASA開發科學文獻專用LLM

IBM和NASA聯手訓練一套Transformer大型語言模型,用科學文獻訓練而成,能進行分類、實體擷取、問答和資訊檢索等各種科學自然語言理解任務。該模型也在Hugging Face上開源,供科學與學術社群使用。

進一步來說,為了讓模型理解科學專有名詞和複合詞,團隊使用來自天文物理學、地球科學與太陽圈物理學等多個專業領域資料集的600億個Token,來訓練模型。後來,團隊用生物醫學基準測試BLURB來評估IBM-NASA模型,分數比其他開源的RoBERTa模型高出5%。這個IBM-NASA模型,可針對許多非生成式語言任務微調,團隊還利用編碼器模型建立檢索器模型,來產生資訊豐富的嵌入向量,映射一對對文字間的相似性,讓檢索模型根據問題,找出最相關的文件或資訊。(詳全文)

Google 社會學習 知識轉移

Google用社會學習優化模型知識轉移能力

Google最近發表一項大型語言模型創新研究,提出社會學習(Social Learning)框架,為模型間的知識傳遞,找出新方法。社會學習能讓語言模型透過自然語言文字交流知識,而且,因為不需直接交換敏感資料或模型權重,還能保有資料隱私。社會學習的概念是,模仿人類在社交環境中,透過口頭指示向其他人學習。在Google提出的社會學習框架中,學生大型語言模型會向多個特定任務解法的教師模型學習,團隊也會評估學生模型在各種任務的表現,來衡量社會學習成效。

他們發現,即使語言模型只接收少數範例,一樣能獲得良好的任務解決能力。而這個方式的重要性在於,教師模型可依據實際資料集,合成出新的範例,與學生共享。特別是,合成資料集雖與原始資料不同,但具相同教育意義,因此,就算教師模型不直接共享真實原始資料,學生模型還是可以從合成資料中學習。實驗結果顯示,當合成範例足夠多,例如只要達到16個,社會學習方法和直接共享原始資料方法的模型解決問題能力就沒有顯著統計上的差異。(詳全文)

/Covariant、微軟、Meta、DeepMind

AI近期新聞

1. Azure OpenAI服務正式上架Whisper模型

2. Amazon提供電商生成AI工具,貼連結就能產生產品頁

3. Patronus AI發表API工具,可用來偵測LLM有否輸出侵權內容

4. GPT-4競爭者報到:Gemini 1.5、Mistral Large、Claude 3 Opus與Inflection-2.5

:iThome整理,2024年3月

2024-03-18

2024-03-18