Google周四(12/7)发布了新的张量处理器(Tensor Processing Unit)Cloud TPU v5p、超级计算机架构AI Hypercomputer,以及资源管理工具Dynamic Workload Scheduler,以协助组织执行与处理AI任务。

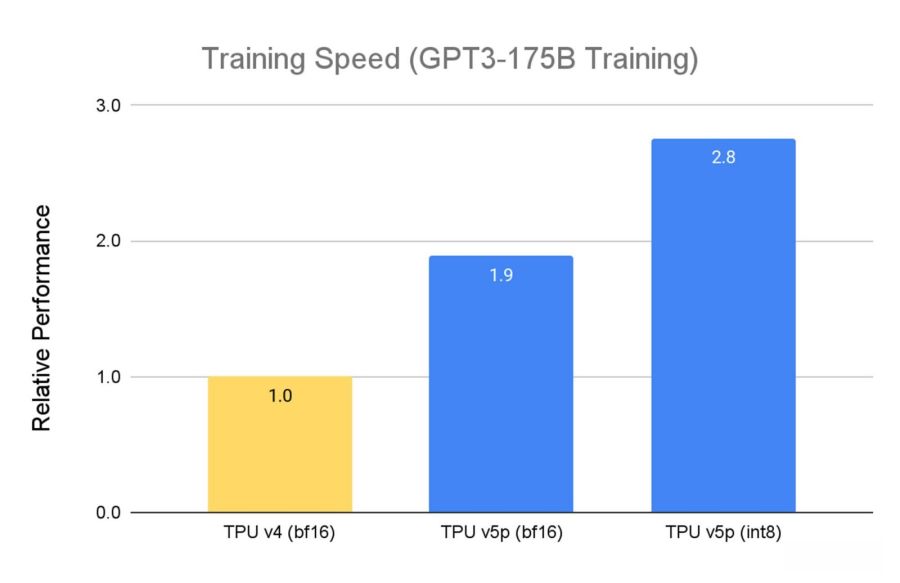

Google始于今年11月推出Cloud TPU v5e,再于本周发布Cloud TPU v5p,前者强调的是成本效益,后者号称是迄今最强大的TPU。每个TPU v5p pod具备8,960个芯片,芯片间的互联速度达4,800 Gbps,相较于上一代的TPU v4,Cloud TPU v5p提供了2倍的FLOPS与3倍的高带宽内存(HBM)。

由于Cloud TPU v5p是性能取向,因此在训练大型LLM模型时的速度,比TPU v4快了2.8倍,在第二代SparseCores的帮助下,TPU v5p训练嵌入式密集模型的速度,也比TPU v4快了1.9倍。

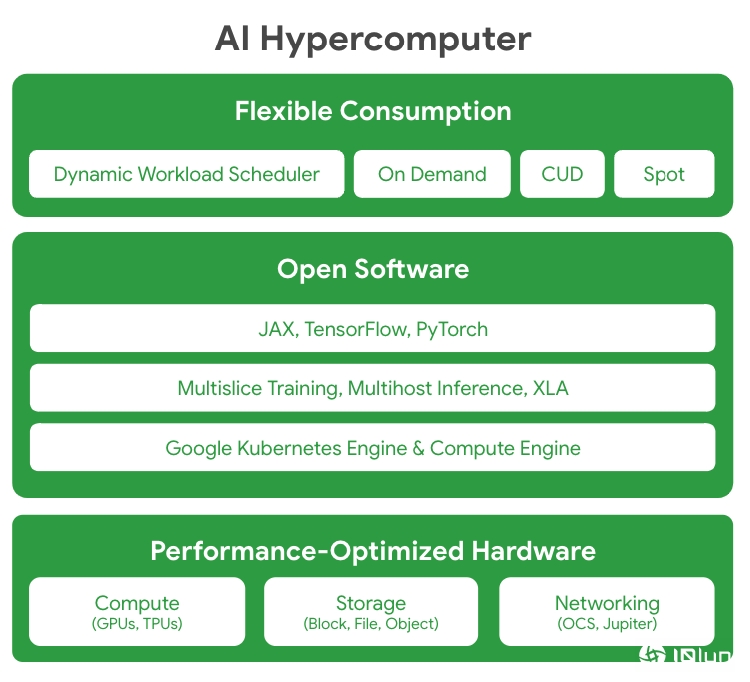

至于AI Hypercomputer则是个超级计算机架构,它集成了优化性能的硬件、开源软件、主要的各种机器学习框架,以及灵活的消费模式。Google解释,传统上通常借由强化分散的组件来处理严苛要求的AI任务,然而,AI Hypercomputer则是利用系统上的协同设计来提高AI在训练、微调与服务上的效率及生产力。

在硬件性能的优化上,AI Hypercomputer具备基于超大规模数据中心基础设施在运算、存储与网络设备的优化设计;也允许开发者通过开源软件来访问相关硬件,以微调与管理AI任务,包括支持JAX、TensorFlow与PyTorch等机器学习框架,以及Multislice Training与Multihost Inferencing等软件,并深度集成了Google Kubernetes Engine(GKE)与Google Compute Engine。

AI Hypercomputer提供了更灵活的消费模式,除了特定用量的折扣(Committed Use Discounts,CUD),以及随选(On-Demand)与竞价(Spot)之外,AI Hypercomputer也借由全新的Dynamic Workload Scheduler,来提供专为AI任务设计的两种消费模式,Flex Start与Calendar。

Dynamic Workload Scheduler为一资源管理及任务调度平台,它支持Cloud TPU与Nvidia GPU,可同时调度所需的所有加速器来协助用户优化支出。其中的Flex Start主要用来微调模型、实验、较短的训练任务、蒸馏、脱机推理及批次任务,并在准备执行请求GPU与TPU容量,是一种相对经济的选择。

而Calendar模式则可替AI任务预留开始时间,适用于需要精确开始时间,与特定持续期间的训练及实验性任务,可于该固定时间的区域中请求GPU容量,所持续的期间可以是7天或14天,最早可提前8周购买。

图片来源/Google Cloud

2023-12-08

2023-12-08